افراد زیادی هستند که تصورات غلطی درباره XML Sitemap (نقشه سایت XML) دارند. اگرچه XML Sitemap ابزار قدرتمندی است؛ اما مانند هر ابزار دیگر، نیاز به آموزش و درک عمیق دارد که در این مقاله به آن پرداخته شده است.

این مطلب نیز ممکن است برای شما مفید باشد: سئو (SEO) چیست؟

فهرست سازی

شاید برخی تصور کنند که نقشه سایت XML به فهرست بندی صفحات شما کمک میکند. این تصور کاملاً اشتباه است. زیرا Google صفحات شما را با توجه به درخواست شما ایندکس نمیکند؛ بلکه (الف) آنها را پیدا و crawl کرده است و (ب) آنها را به اندازه کافی با کیفیت دیده است که ارزش ایندکس شدن را داشته باشد. بنابراین نمایش صفحات برای Google تأثیری در فهرست بندی آنها ندارد.

با این حال، ذکر این نکته مهم است که با ارسال XML Sitemap به کنسول جستجوی گوگل، به گوگل سرنخی میدهید که صفحات موجود در آن را به عنوان صفحات با کیفیت و شایسته برای فهرست بندی میدانید. اما، دقت کنید که این فقط یک سرنخ است. مانند پیوند دادن به یک صفحه از منوی اصلی شما.

ثبات

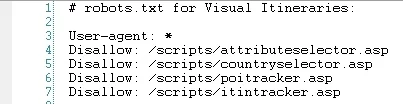

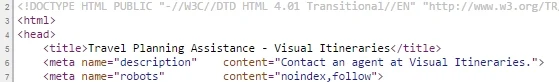

یکی از رایجترین اشتباهاتی که میبینم کاربران مرتکب میشوند این است که در پیامرسانی به Google در مورد یک صفحه خاص، یکنواخت نیستند. اگر صفحهای را در robots.txt مسدود کنید و سپس آن را در نقشه سایت XML قرار دهید، یک عمل کاملاً متناقض انجام دادهاید. زیرا XML Sitemap شما میگوید: "این صفحه باید ایندکس شود." و سپس robots.txt تأثیر آن را از بین میبرد. در مورد meta robotها هم همینطور: صفحه مورد نظر را در نقشه سایت XML قرار ندهید و سپس meta robotها را "noindex,follow" تنظیم نمایید که در آن، "noindex" به معنای عدم فهرست بندی صفحه است و "Nofollow" به این معنی است که "پیوندهای خروجی از آن صفحه را دنبال نکند".

بنابراین، به طور کلی، شما میخواهید هر صفحه در سایت شما در دو دسته قرار گیرد:

- صفحات سودمند (برای کاربران مفید است، اما چیزی نیست که انتظار داشته باشید، صفحه فرود جستجو باشد)

- صفحات فرود جستجوی جالب و با کیفیت بالا

همه چیز در دسته شماره 1 یا باید توسط robots.txt؛ یا از طریق متا روبات "noindex,follow" مسدود شود و بنابراین نباید در XML sitemap باشد.

همه چیز در دسته شماره 2 نباید در robots.txt مسدود شود، نباید متا روبات "noindex" داشته باشد و احتمالاً باید در XML sitemap باشد.

کیفیت کلی سایت

به نظر میرسد که گوگل مقداری از کیفیت کلی سایت را در نظر میگیرد و از این معیار در سطح سایت برای تأثیرگذاری بر رتبه بندی استفاده میکند.

به منظور درک آن باید از دیدگاه گوگل به این موضوع فکر نمایید. فرض کنید یک صفحه عالی پر از محتوای شگفتانگیز دارید. اگر گوگل سایت شما را به عنوان 1000 صفحه محتوا ببیند که تنها 5 تا 6 صفحه آن عالی است. اکنون اگر گوگل کاربری را به یکی از آن صفحات عالی بفرستد، تجربه کاربر با مشاهده محتوا و لینکها چگونه خواهد بود؟ یک لینک در آن صفحه و بازدید از چیز دیگری در سایت شما؟ به احتمال زیاد، آنها در صفحهای قرار میگیرند که بد است. بنابراین چرا گوگل بخواهند کاربر را به چنین سایتی بفرستند؟

مهندسان گوگل مطمئناً میدانند که هر سایتی دارای تعداد معینی از صفحات کاربردی است که برای کاربران مفید است، اما نه لزوماً صفحاتی از نوع محتوایی که باید صفحات فرود از جستجو (صفحاتی برای اشتراکگذاری محتوا با دیگران، پاسخ دادن به نظرات، ورود به سیستم، بازیابی رمز عبور گم شده و غیره) باشند.

اگر نقشه سایت XML شما شامل همه این صفحات باشد، چه چیزی را با گوگل در میان میگذارید؟ بدین صورت شما هیچ سرنخی از اینکه چه محتوایی در سایت شما خوب است و چه چیزی خوب نیست، ارائه نکردهاید.

این تصویری است که میخواهید به جای آن برای Google ترسیم کنید. بله، ما یک سایت با 1000 صفحه داریم که 475 مورد از آن 1000 صفحه، محتوای عالی ما هستند. در این صورت میتوان بقیه را نادیده گرفت.

حال، فرض کنید گوگل آن 475 صفحه را crawl کرده و با معیارهای آن، تصمیم میگیرد که 175 مورد از آنها دارای درجه A و 200 مورد B+ و 100 صفحه را B یا B- در نظر بگیرد. این یک میانگین کلی بسیار خوب است و احتمالاً نشان دهنده یک سایت کاملاً قوی برای ارسال کاربران به آن است.

آن را با سایتی مقایسه نمایید که همه 1000 صفحه را از طریق XML sitemap ارسال میکند. اکنون، گوگل به 1000 صفحهای که از نظر شما عالی هستند، نگاه میکند و میبیند که بیش از 50٪ صفحات "D" یا "F" هستند. به طور متوسط، سایت شما بسیار ضعیف در نظر گرفته میشود و گوگل کاربران را به چنین سایتی نمیفرستد.

اشتباه پنهان

به یاد داشته باشید، Google از آنچه در نقشه سایت XML خود ارسال میکنید، به عنوان سرنخی برای آنچه احتمالاً در سایت شما مهم است استفاده میکند. اما اگر صفحهای در نقشه سایت XML شما وجود نداشته باشد، لزوماً به این معنی نیست که Google آن صفحات را نادیده میگیرد. شما هنوز هم میتوانید هزاران صفحه با محتوا و ارزش لینک کافی برای فهرست بندی داشته باشید.

شما باید تمام صفحاتی را که گوگل از سایت شما ایندکس کرده است، جستجو نمایید تا صفحاتی را که فراموش کردهاید، پیدا نمایید و آنهایی را که از نظر Google در رده متوسط قرار دارند، با تنظیم meta robot برروی "noindex,follow" یا مسدود کردن در robots.txt پاک کنید.

Noindex در مقابل robots.txt

یک تفاوت مهم اما ظریف بین استفاده از meta robot و استفاده از robots.txt برای جلوگیری از فهرست سازی یک صفحه وجود دارد. استفاده از متا رباتهای "noindex,follow" به لینکی که به آن صفحه میرود اجازه میدهد تا به صفحاتی که به آن پیوند داده میشود، جریان پیدا کند و اگر صفحه را با robots.txt مسدود نمایید، مثل این است که آن را در سطل زباله بریزید.

در مثال بالا، صفحاتی را مسدود میکنیم که صفحات واقعی نیستند؛ بلکه آنها اسکریپتها را ردیابی مینمایند. بنابراین ارزش پیوند را از دست نمیدهیم؛ زیرا این صفحات، سرآیند(header)ی با پیوندهای منوی اصلی و ... ندارند.

صفحهای مانند صفحه تماس با ما یا صفحه سیاست حفظ حریم خصوصی را در نظر بگیرید. احتمالاً هر صفحه در سایت شما از طریق منوی اصلی یا منوی پاورقی به آن پیوند داده شده است. بنابراین، حجم زیادی از پیوند به آن صفحات وجود دارد. به نظر شما باید آن را دور بریزید؟ یا ترجیح میدهید اجازه دهید که ارزش پیوند به همه چیز در منوی اصلی شما سرازیر شود؟

مدیریت پهنای باند Crawl کردن

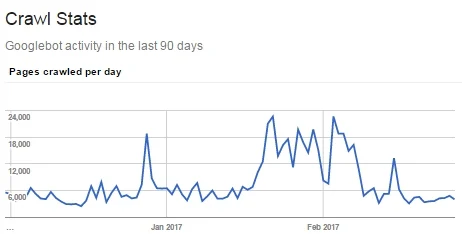

چه زمانی ممکن است بخواهید به جای آن از robots.txt استفاده کنید؟ شاید اگر مشکل پهنای باند crawl کردن را دارید و Googlebot زمان زیادی را صرف واکشی صفحات ابزار (تنها برای کشف متا روباتهای "noindex,follow" در آنها) میکند. اگر تعداد زیادی از این موارد را دارید که باعث میشود Googlebot به صفحات مهم شما نرسد، بهتر است از طریق robots.txt آن را مسدود نمایید.

اگر مجموعهای اصلی از صفحات دارید که در آن محتوا به طور منظم تغییر میکند (مانند وبلاگ، محصولات جدید یا صفحات دسته بندی محصول) و تعداد زیادی صفحه (مانند صفحات تک محصولی) دارید که از نظر SEO با کیفیت است و ارزش فهرست بندی در Google را دارد، اما نه به قیمت crawl کردن مجدد و ایندکس کردن صفحات اصلی، شما میتوانید صفحات اصلی را در یک XML sitemap ارسال کنید تا به گوگل سرنخی بدهید که آنها را مهمتر از صفحاتی که مسدود نشدهاند (ولیکن در sitemap قرار ندادهاید) میدانید.

اشکال زدایی مشکل فهرست سازی

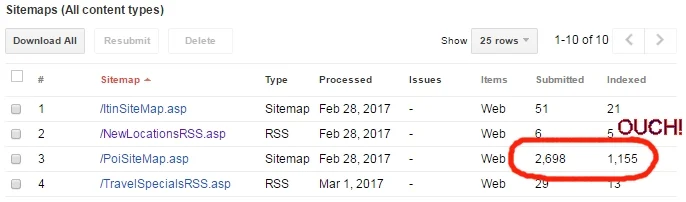

اینجاست که XML sitemap واقعاً برای سئوکاران مفید است: زمانی که شما دستهای از صفحات را برای فهرست سازی به گوگل ارسال میکنید و فقط برخی از آنها واقعاً فهرست سازی میشوند. در آخر نیز کنسول جستجوی گوگل به شما نمیگوید که کدام صفحات فهرست بندی میشوند؛ بلکه تنها یک عدد کلی تعداد صفحات فهرست بندی شده برای هر XML sitemap تعیین میشود.

فرض کنید شما یک سایت تجارت الکترونیک دارید که 100000 صفحه محصول، 5000 صفحه دسته بندی و 20000 صفحه زیرمجموعه دارد. نقشه سایت XML خود را با 125000 صفحه ارسال میکنید و متوجه میشوید که گوگل 87000 صفحه از آنها را ایندکس میکند. اما کدام 87000 صفحه را؟ مشخص نیست!

اول از همه، صفحات دسته و زیر شاخه شما احتمالاً همه اهداف جستجوی مهم برای شما هستند. در اینجا فرض کنید که یک دسته sitemap.xml و یک زیردسته subcategory-sitemap.xml ایجاد کرده و آنها را جداگانه ارسال نمودهایم. انتظار دارید که نزدیک به 100٪ فهرست بندی را در آنجا مشاهده کنید و اگر چنین چیزی را دریافت نکردید، پس میدانید که باید به دنبال ایجاد محتوای بیشتر بر روی آنها، افزایش پیوند به آنها و یا هر دو باشید. ممکن است چیزی مانند صفحههای دستهبندی یا زیرشاخههای محصول را پیدا کنید که فهرست بندی نشدهاند؛ زیرا تنها 1 محصول در خود دارند (یا اصلاً هیچ محصول). در این صورت احتمالاً میخواهید متا رباتها را روی «noindex,follow» تنظیم کرده و آنها را از نقشه سایت XML بیرون بیاورید.

به احتمال زیاد، مشکل در برخی از 100000 صفحه محصول نهفته است، اما کدام یک؟ مشخص نشده است!

این مطلب نیز ممکن است برای شما مفید باشد: فایل Robots.txt

با یک فرضیه شروع کرده و صفحات محصول خود را به XML sitemapهای مختلف تقسیم نمایید تا این فرضیهها را آزمایش کنید. دقت نمایید که شما میتوانید، چندین کار را همزمان انجام دهید و وجود یک URL در چندین نقشه سایت هیچ مشکلی ندارد.

ممکن است با 3 نظریه شروع کنید:

- صفحاتی که تصویر محصول ندارند، فهرست بندی نمیشوند.

- صفحاتی که کمتر از 200 کلمه توصیف منحصر به فرد دارند، فهرست نمیشوند.

- صفحاتی که دارای نظرات کاربران نیستند، فهرست بندی نمیشوند.

یک XML sitemap با تعداد قابل توجهی از صفحات ایجاد کنید که در هر یک از آن دسته بندیها قرار میگیرند. لازم نیست همه صفحات در آن دسته باشد؛ بلکه تنها به اندازهای که حجم نمونه، نتیجه گیری بر اساس فهرست سازی را معقول کند، کافی است. برای مثال ممکن است در هر کدام 100 صفحه قرار دهید.

هدف شما در اینجا این است که از درصد فهرست سازی کلی هر نقشه سایت برای شناسایی ویژگیهای صفحاتی که باعث ایندکس شدن یا ایندکس نشدن آنها میشود، استفاده نمایید.

هنگامیکه متوجه شدید مشکل چیست، شما میتوانید محتوای صفحه (یا پیوندهای صفحهها) را تغییر دهید یا صفحات را فهرستبندی نکنید. برای مثال، ممکن است 20000 صفحه از 100000 صفحه محصول خود را داشته باشید که در آن، توضیحات محصول کمتر از 50 کلمه باشد. اگر این عبارات پربازدید نیستند، احتمالاً ارزش آن را ندارد که تلاش کنید و به صورت دستی 200 کلمه توضیحات اضافی برای هر یک از آن 20000 صفحه بنویسید. شما میتوانید متا رباتها را برای همه صفحاتی که کمتر از 50 کلمه توضیح محصول دارند، برروی «noindex,follow» تنظیم کنید؛ زیرا گوگل به هر حال آنها را ایندکس نمیکند و آنها فقط رتبهبندی کلی کیفیت سایت شما را پایین میآورند. در آخر، فراموش نکنید که آنها را از نقشه سایت XML خود حذف نمایید.

XML sitemap پویا

احتما شما در این فکر هستید که باید نقشه سایت XML خود را به صورت دستی با meta robot خود در تمام 100000 صفحه خود هماهنگ نمایید و به احتمال زیاد این اتفاق نمیافتد.

جواب این است که نیازی به انجام دستی این کار نیست. XML sitemapها نباید فایلهای ثابت باشند. در واقع، آنها حتی نیازی به داشتن پسوند .XML برای ارسال آنها در کنسول جستجوی گوگل ندارند.

در عوض باید منطق قواعدی را تنظیم نمایید که آیا یک صفحه در نقشه سایت XML گنجانده میشود یا خیر، و از همان منطق در خود صفحه برای تنظیم index یا noindex متا روبات استفاده کنید. به این ترتیب، لحظهای که توضیحات محصول بهروزرسانی میشود و از 42 کلمه به 215 کلمه میرسد، آن صفحه در سایت شما به طور جادویی در XML sitemap نشان داده شده و متا روباتها آن را روی «index,follow» تنظیم مینمایند.

منبع:

moz

دستور apt در لینوکس

دستور apt در لینوکس  ایجاد و اجرای Docker Image با استفاده از Dockerfile

ایجاد و اجرای Docker Image با استفاده از Dockerfile  Soft Link و Hard Link در لینوکس

Soft Link و Hard Link در لینوکس  غیرفعال سازی دسترسی SSH به روتر میکروتیک

غیرفعال سازی دسترسی SSH به روتر میکروتیک

0 دیدگاه

نوشتن دیدگاه